Introduction

Les logiciels libres et l’écosystème Linux portent des promesses réelles en matière d’ouverture et d’innovation, mais ils posent aussi des défis concrets pour la souveraineté numérique lorsqu’ils reposent massivement sur des chaînes de dépendances et des dépôts maintenus par des tiers. Ces dépendances exposent les organisations à des risques de supply chain, de perte de contrôle juridique et d’obsolescence.

À l’inverse, des solutions propriétaires on‑premise, en particulier les environnements Microsoft Windows Server et les postes Windows, offrent souvent une maîtrise opérationnelle, matérielle et juridique plus immédiate pour les entreprises et les particuliers.

L’innovation stratégique ne passe pas uniquement par le logiciel et l’open source ; le marché du gaming sous Windows a financé des ruptures matérielles — notamment l’essor des GPU — qui profitent aujourd’hui à la recherche, à la météo et à l’IA.

Une lecture pragmatique doit distinguer local (on‑premise) et distant (cloud) et mesurer la gouvernance effective, pas seulement l’étiquette « open source » ou « propriétaire »

1. L’enfer des dépendances dans l’écosystème libre

- Les projets libres modernes s’appuient massivement sur des centaines voire des milliers de paquets distribués via des gestionnaires et dépôts en ligne (npm, PyPI, crates.io, etc.).

- Ils sont souvent maintenus par des contributeurs bénévoles et hébergés sur des serveurs dont la localisation et le régime juridique sont inconnus.

- Bon nombre sont hébergés par des comptes individuels, sans aucune garantie légale, ni identité vérifiée, parfois sans authentification multi facteurs.

« Bon nombre des packages du top 500 de nos listes sont hébergés par des comptes de développeurs individuels. Les conséquences d’une telle dépendance à ces comptes ne doivent pas être sous-estimées. Pour des raisons juridiques, administratives et de sécurité, les comptes de développeurs individuels bénéficient, dans la plupart des cas, de moins de protections que les comptes d’organisation. Bien que ces comptes puissent utiliser des mesures telles que l’authentification multifacteur (MFA), ils ne le font pas toujours, ce qui rend les environnements informatiques individuels plus vulnérables aux attaques. De plus, ces comptes ne bénéficient pas de la même granularité en matière d’autorisations et autres contrôles de publication que les comptes d’organisation. Cela signifie que les modifications du code sous le contrôle de ces comptes de développeurs individuels sont nettement plus faciles à effectuer. »

La Fondation Linux – Census III of Free and Open Source Software – Décembre 2024

- Les incidents récents sur l’écosystème npm montrent l’ampleur du problème : des paquets massivement téléchargés ont été compromis et utilisés pour propager du malware, démontrant la portée d’une attaque sur les dépôts publics et la capacité d’affecter des millions d’applications en amont et en aval.

- Cette fragilité opérationnelle et juridique rend la souveraineté numérique délicate : disparition d’un dépôt, abandon d’un mainteneur, ou modification malveillante d’un paquet peuvent forcer des migrations imprévues ou casser des chaînes de production.

- La disponibilité, la localisation des serveurs hébergeant les dépôts et le modèle de gouvernance sont donc très variables, ce qui complique toute garantie de continuité ou d’application des règles de souveraineté (juridiction, stockage des métadonnées, accès aux logs).

- Les recommandations issues d’analyses du secteur soulignent la nécessité d’une gouvernance et d’un inventaire du logiciel libre à l’échelle des organisations pour gérer ces risques. Des études et synthèses récentes montrent que l’écosystème FOSS est omniprésent en production, mais que son modèle d’entretien soulève des problèmes de sécurité, de maintenance et d’évolutivité.

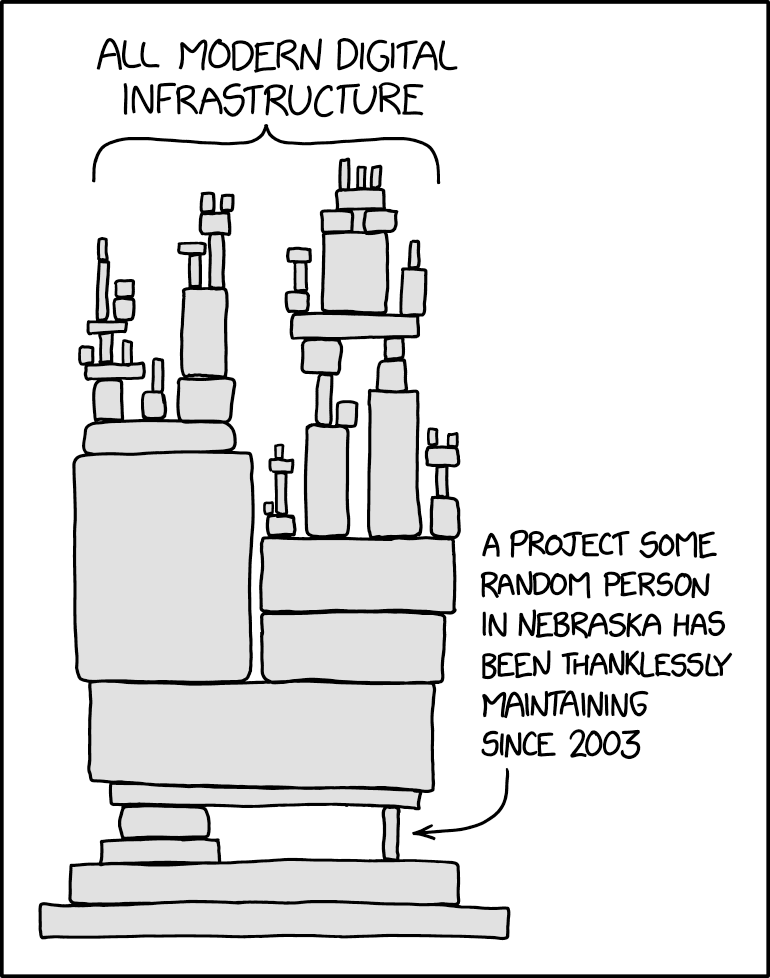

L’exemple le plus emblématique des difficultés et risques associés aux pratiques actuelles du FOSS est celui de l’incroyable histoire de la compromission du module XZ Utils découverte en mars 2024.

Un projet, à la base personnel et de loisir, est devenu au fil des ans une brique essentielle de certaines distributions de Linux installées au cœur des datacenters mondiaux. Le projet était maintenu sur un compte individuel par une personne seule et isolée qui, arrivée à épuisement, a fini par le céder à un autre contributeur dont l’identité réelle est toujours totalement inconnue à ce jour. Ce dernier a injecté du code malveillant dans le projet et a rapidement contaminé des milliers de serveurs sur la planète entière via la supply chain. Malgré l’ouverture du code et le supposé foisonnement de relecture par la communauté, une brique importante, largement partagée par de nombreux autres développeurs et mise en production à grande échelle, a été confiée de façon totalement informelle à un tiers inconnu et au demeurant malveillant. On tombe littéralement dans la caricature de xkdc.

Sources :

- https://www.linuxfoundation.org/hubfs/LF%20Research/lfr_censusiii_120424a.pdf

- NPM : un malware infiltre des paquets très populaires !

- XZ Utils : comment une porte dérobée dans un composant de Linux a fait craindre le pire – Next

2. Difficultés techniques du développement sous Linux

- Fragmentation des distributions et versions : fournir des binaires stables pour Debian, Ubuntu, Fedora, Red Hat, Arch et leurs multiples versions requiert du packaging, des tests et des mainteneurs spécifiques par cible, complexifiant la livraison. Les ruptures d’ABI à cause d’une mise à jour de glibc sont fréquentes, ce qui complique la tâche des développeurs et nuit à la pérennité à long terme des packages.

- Fragmentation des environnements et toolkits graphiques : QT vs GTK, X11 vs Wayland, GNOME vs KDE rendent l’UX, le comportement et les dépendances très variables, poussant de nombreux projets vers des interfaces web uniformisées mais distantes, ou ne disposent pas d’interface graphique et s’exécutent uniquement en ligne de commande.

- Prévalence d’outils non compilés : scripts, applications distribuées sous forme de source, ou dépendant d’un écosystème de packages (pip, npm, gems) obligent à reconstruire ou installer des chaînes d’outils à la volée.

- Tendance web/cloud du développement : la concentration sur des applications web et des frontends accessibles via navigateur réduit l’effort pour optimiser des exécutions locales compilées, souvent plus efficaces énergétiquement. Poids croissant de JavaScript et des API Google dans les applications libres.

- Dépendance aux mainteneurs bénévoles : de nombreux paquets critiques sont maintenus par une ou deux personnes, créant un point de rupture humain en cas d’abandon. Ces caractéristiques rendent le développement et l’exploitation sous Linux plus exigeants en gestion de dépendances, packaging et gouvernance.

Sources :

- Valve Employee: glibc not prioritizing compatibility damages Linux Desktop : r/linux_gaming

- Win32 Is The Only Stable ABI on Linux

- Not breaking userspace: the evolving Linux ABI | 19x

- glibc breaks ABI quite often. Linus has roasted about it openly in the past http… | Hacker News

- Linus Torvalds on why desktop Linux sucks (vidéo Youtube)

3. Conséquences pour la sécurité et la souveraineté numérique

- Perte de maîtrise juridique et opérationnelle : dépendre de dépôts étrangers implique de subir des lois locales, des politiques d’exportation et des interruptions d’accès hors du contrôle du responsable souverain (État, entreprise).

- Risque d’attaque sur la supply chain : compromission d’un compte de mainteneur, injection de code malveillant dans une dépendance critique ou suppression d’un paquet libère des effets en cascade qui touchent la disponibilité et la sécurité des systèmes.

- Dépendance au réseau et gaspillage énergétique : le modèle de mises à jour et de builds fréquents multiplie les échanges vers des datacenters distants, augmente le trafic et la consommation d’énergie comparé à des binaires stables et compilés localement.

- Risque d’érosion de l’autonomie lors des migrations : faute d’applications natives complètes, on bascule souvent vers des services cloud (distants) qui réduisent la souveraineté au lieu de l’augmenter.

4. Comparaison pratique : on‑premises Windows vs écosystème Linux libre

- Contrôle on-premise : les environnements Microsoft Windows Server (AD, DHCP, DNS, Exchange, IIS) permettent de gérer intégralement un réseau d’entreprise et les données en local, sans nécessairement recourir au cloud, offrant un contrôle clair sur la localisation des services et des backups. Windows fournit des interfaces graphiques consolidées et des outils d’administration centralisés appréciés en entreprise. Le manque de solutions natives sous Linux peut pousser vers des solutions cloud, ce qui est contraire à l’objectif de souveraineté numérique.

- Administration centralisée : l’intégration native de la gestion des groupes, du modèle d’ACL et des groupes imbriqués facilite l’administration à grande échelle comparée aux solutions Linux (SSSD, winbind) souvent plus fragmentées et limitées. Linux ne supporte pas les groupes imbriqués par exemple, rendant la gestion centralisée complexe et fastidieuse.

- Standards industriels : contrairement à l’idée reçue d’une « boîte noire », Windows respecte la plupart des standards industriels (LDAP, Kerberos, SMB, TLS, etc) et offre une large compatibilité matérielle et logicielle, facilitant l’intégration hétérogène dans des environnements mixtes. Cela favorise un écosystème logiciel/matériel riche et divers pour tous les usages numériques, particuliers comme entreprises.

- Environnement de développement puissant, stable et ouvert : La suite Visual Studio permet de développer des applications graphiques natives stables dans le temps, offre le choix entre une multitude de langages, et permet aussi de compiler des applications pour Android (avec .NET MAUI). Pas de « store » imposé ni de commission à payer sous Windows, contrairement aux environnements Apple et Android qui n’offrent pas autant de liberté de développement et de distribution libre des applications. Pouvoir développer et distribuer librement et facilement des logiciels est un pilier de la souveraineté numérique.

- Pérennité des paquets : Sous Windows, les bibliothèques d’exécution (CRT, UCRT, librairies Visual C++) sont conçues pour être redistribuées avec l’application ou installées comme composants side‑by‑side, réduisant la dépendance à une libc « système » unique et aux mises à jour imprévues. Tandis que les solutions Linux peuvent nécessiter recompilation ou ajustements à chaque évolution majeure des dépendances. Les packages Windows compilés et encapsulés ont souvent une longévité opérationnelle élevée et restent fonctionnels des années après compilation, sans dépendance à des dépôts volatils et des mainteneurs. Cela est un atout pour la sécurité et la souveraineté en facilitant les inventaires et audit logiciels.

- Expérience utilisateur : sous Windows l’expérience bureau, les gestionnaires de fichiers et les interfaces graphiques (gestion aisée des fichiers, installation logicielle) facilitent pour l’utilisateur moyen le contrôle de ses données sans recourir à des services distants. Les utilisateurs moyens préfèrent souvent la simplicité d’un explorateur de fichiers et d’installateurs clairs plutôt que les interfaces en ligne de commande obligeant à des cherches sur internet même pour des actions basiques. Le système de fichier Linux et son arborescence sont peu lisibles pour un utilisateur moyen, diminuant sa souveraineté numérique.

5. Innovation matérielle et rôle de Windows dans l’écosystème

- Contrairement à certaines idées reçues, l’innovation numérique ne passe pas uniquement par le logiciel et le code ouvert. Elle dépend autant du matériel que du logiciel. L’évolution des composants (CPU, GPU, RAM, stockage, refroidissement) permit aux logiciels de gérer des volumes et des paramètres croissants.

- Windows est la plateforme majoritaire (95.4% de PDM sur Steam en septembre 2025, contre 2.68% pour Linux et 1.92% pour MacOS) qui fédère l’industrie et facilite économies d’échelle et adoption rapide. Les jeux vidéo ont été le moteur la compétition pour les performances gaming a entraîné des gains massifs en CPU/GPU exploitables ensuite pour le calcul scientifique et l’IA. La réalité virtuelle (VR) exigeante en GPU (rendu 3D stéréoscopique) est utilisée en ingénierie et en jeu, avec un écosystème PC riche (casques compatibles Windows, catalogue de jeux Steam).

- L’écosystème Windows, par son équilibre entre propriétaire et compatibilité, a fédéré fabricants, développeurs et utilisateurs, stimulant la R&D matérielle et l’adoption à grande échelle. Le marché du jeu vidéo grand public a poussé les limites de performance du hardware, ces avancées ayant ensuite bénéficié aux serveurs, supercalculateurs, simulations, réalité virtuelle et IA. Les progrès matériels rendent possibles des traitements logiciels de plus en plus complexes utilisés par la météo et l’ingénierie par exemple.

- Les acteurs historiques Intel, AMD et Nvidia, ont évolué grâce au marché Windows pour atteindre les usages HPC et IA. Le financement indirect du loisir a généré des externalités positives sur l’ensemble de la filière matérielle.

- L’importance conjointe du hardware et du software implique que les stratégies d’innovation doivent soutenir simultanément la R&D matérielle et logicielle, tirer parti d’écosystèmes larges pour réduire les coûts unitaires, et reconnaître le rôle des marchés grand public (jeux, VR) comme catalyseur d’avancées techniques utiles aux usages professionnels.

- Le progrès numérique est co-dépendant du matériel et du logiciel, et l’écosystème Windows plus le marché du jeu ont accéléré l’amélioration du hardware au bénéfice de l’ensemble de l’informatique.

Sources :

- https://store.steampowered.com/hwsurvey/Steam-Hardware-Software-Survey-Welcome-to-Steam

- Le 3D sketching offre de nouvelles perspectives au Design

- https://www.lemagit.fr/actualites/366620469/A-la-rencontre-dAlps-le-second-plus-puissant-supercalculateur-dEurope

- https://meteofrance.com/actualites-et-dossiers-0/les-supercalculateurs-de-meteo-france

6. Cloud, Linux et fausses promesses de pérennité

- Distinction local versus distant : confondre Windows (OS) et Microsoft Cloud (service distant) fausse le débat — on peut être souverain avec Windows on‑premise ou perdre souveraineté avec des services cloud, quel que soit l’OS.

- Le cloud ne garantit pas la pérennité : pertes d’accès, incidents majeurs ou incendies de centres de données existent; des pannes géantes d’outillages cloud sont déjà survenues et montrent une centralisation du risque qui peut affecter des milliers d’organisations simultanément. La panne géante d’AWS du 20 octobre 2025 ou encore l’incroyable perte de 858 To de données publiques de l’État sud-coréen à cause de l’incendie du cloud gouvernemental G-Drive, sont des exemples flagrants.

- Surface d’attaque et surface d’exposition : les services cloud multiplient les interfaces externes et la complexité, offrant souvent une surface d’attaque supérieure à des services on‑premise bien durcis, y compris les services Cloud Microsoft 365 qui au final sont plus exposés que leurs systèmes on-premise. Des attaques par phishing peuvent même compromettre la double authentification (MFA).

- Le cloud est antinomique de la souveraineté numérique : Bien qu’utile, voire indispensable pour certains échanges et certaines configurations, le cloud en soi est à divers degrés une perte de souveraineté par rapport à des solutions on-premise. Il s’agit forcément de déléguer le contrôle d’une partie de l’infrastructure numérique à un tiers distant et de s’en rendre dépendant dans une certaine mesure. Le fournisseur d’une solution Cloud peut unilatéralement mettre fin à votre accès au service et à vos données, ou imposer des changement profonds dans les conditions d’utilisations (lock-in).

- La pérennité à moyen/long terme sous Linux n’est pas garantie : Outre les packages et dépendances qui peuvent changer ou disparaître, ce sont parfois des distributions entières de Linux qui disparaissent, laissant les utilisateurs seuls face à des migrations complexes. La disparition brutale de CentOS sur décision de Red Hat est un exemple marquant.

- Linux n’est pas synonyme de sécurité absolue : des distributions et logiciels d’entreprise peuvent être victimes de failles ou de piratages (ex. incidents touchant des distributions ou paquets critiques), ce qui rappelle qu’aucun modèle n’est intrinsèquement invulnérable.

- Chiffres récents sur les infections Linux :

- Le botnet Ebury a infecté environ 400 000 serveurs Linux depuis 2009, soit une moyenne de 26 000 infections par an, avec 100 000 machines encore compromises fin 2023.

- Un autre malware nommé perfctl a discrètement infiltré des milliers de systèmes Linux pendant plusieurs années, en exploitant des erreurs de configuration courantes.

- Les statistiques globales sur les malwares montrent une augmentation constante des infections en entreprise, y compris sur des postes Linux, avec des taux de propagation atteignant 75 % en 2022 dans certains environnements.

- Le botnet Ebury a infecté environ 400 000 serveurs Linux depuis 2009, soit une moyenne de 26 000 infections par an, avec 100 000 machines encore compromises fin 2023.

Seule une approche globale de la souveraineté numérique faite de briques on-premise et cloud peut faire la différence. Ne pas penser que le cloud et Linux à eux seuls résolvent toutes les problématique de configuration, de sécurité, de sauvegarde, de dimensionnement et de redondance des infrastructures informatiques et numériques. Bien évaluer les possibilités de récupération et de migration des des données et des outils d’un fournisseur cloud à une autre. Les outils SaaS peuvent conduire à des enfermements (lock-in) plus difficiles à contourner que les solutions on-premise.

Sources :

- https://www.lebigdata.fr/la-panne-aws-relance-le-debat-sur-le-multicloud-en-2025

- https://cloud-computing.developpez.com/actu/376448/Un-incendie-detruit-completement-un-systeme-de-stockage-cloud-du-gouvernement-sud-coreen-et-aucune-sauvegarde-n-est-disponible-647-systemes-critiques-du-pays-ont-ete-mis-hors-service-par-l-incendie/

- Pour contourner le MFA, des pirates falsifient des apps OAuth de Microsoft – Le Monde Informatique

- https://itsocial.fr/contenus/articles-decideurs/comprendre-le-vendor-lock-in-les-defis-de-la-mobilite-numerique-des-entreprises/

- https://www.it-connect.fr/depuis-2009-botnet-ebury-a-infecte-400-000-serveurs-linux/

- https://www.itrust.fr/focus-sur-perfctl-le-malware-ciblant-les-systemes-linux

7. Code ouvert : moins de confidentialité pour plus de sureté ?

- Le partage du code n’est pas une panacée pour la souveraineté : certains secteurs sensibles exigent des composants propriétaires ou audités par des tiers qualifiés; l’ouverture du code à tous n’est pas toujours souhaitable ou pertinente. Les données et les traces réseau sont souvent l’enjeu principal : contrôler où les données résident, qui y accède et comment elles transitent est plus critique que la seule ouverture du code; la visibilité du code n’élimine pas nécessairement les risques opérationnels ou juridiques.

- La croyance que le code ouvert permet à la communauté de détecter les failles à temps ne se vérifie pas dans les faits. De nombreuses failles de sécurité dans du code ouvert perdurent des années avant d’être détectées et corrigées. Certaines menaces comme Perfctl (2021) ou Ebury (2009!) sévissent depuis des années sans aucune réaction de la communauté FOSS qui reste mutique, voire occulte ces incidents graves touchant des dizaines de milliers de systèmes Linux chaque année.

- Beaucoup d’anomalies profondes dans des projets FOSS largement réutilisés sont détectées par des acteurs institutionnels ou des entreprises plutôt que par la communauté bénévole. La faille Log4j était présente dans le code source ouvert aux yeux de tous depuis 2013 avant de n’être détectée qu’en 2021, par des chercheurs du géant du commerce en ligne Alibaba. Celle de XZ utils a été découverte par un ingénieur de Microsoft.

« Les mainteneurs de Log4j ont travaillé sans sommeil sur des mesures d’atténuation ; correctifs, docs, CVE, réponses aux demandes de renseignements, etc. Pourtant, rien n’empêche les gens de nous critiquer, pour un travail pour lequel nous ne sommes pas payés, pour une fonctionnalité que nous détestons tous, mais que nous devions conserver en raison de problèmes de compatibilité ascendante »

Volkan Yazıcı, Apache Software Foundation – 10 décembre 2021

Sources :

8. Culture open source dominante : incohérences, biais et dogmatismes

Les risques et difficultés rencontrées avec le développement FOSS n’est pas uniquement du aux difficultés purement techniques de Linux et des dépendances, cela résulte aussi, et surtout, d’une culture technique biaisée et dévoyée. Pourquoi ? Parce qu’une culture dominante, fondée sur des croyances simplistes et une abstraction excessive, a déconnecté les développeurs des réalités matérielles, réseau et système. Il existe effectivement une frange dogmatique qui croit en une sécurité “absolue” de Linux ou du libre, souvent sans comprendre les vecteurs d’attaque modernes (supply chain, cloud misconfigurations, kernel exploits). Les forums regorgent de discours simplistes du type “Windows = spyware, Linux = liberté”, qui occultent les réalités opérationnelles. Une partie de la communauté web (notamment JavaScript full-stack) ignore ou sous-estime les disciplines comme la sécurité réseau, l’architecture système ou la gestion des permissions. Cela mène à des configurations naïves, des stockages non chiffrés, des CORS mal gérés, etc.

Déconnexion des disciplines IT :

- Méconnaissance du réseau : Peu de développeurs comprennent les ACL, les VLAN, les firewalls, ou les modèles de segmentation.

- Ignorance du hardware : CPU, RAM, I/O, microcode, firmware… sont des zones grises pour beaucoup. Résultat : surprovisionnement, mauvaise optimisation, et vulnérabilités physiques.

- Cloud-first, boîte noire : L’abstraction du cloud masque les réalités matérielles, réseau, et système. Les développeurs ignorent souvent où tourne leur code, sur quel matériel, avec quelles protections.

- Effet DevOps sans DevSec : L’automatisation prime sur la sécurité. Les pipelines CI/CD déploient du code sans contrôle rigoureux des dépendances ou des configurations.

Mythe de la supériorité open source :

- Transparence ≠ sécurité : Le code ouvert ne garantit rien sans audit, maintenance et gouvernance. En pratique, beaucoup de projets critiques sont sous-maintenus, avec peu de relectures ou de tests de sécurité. La faille Log4Shell est restée invisible pendant des années malgré le code ouvert.

- Dogmatisme et mythes Linux : Beaucoup croient que Linux est “intrinsèquement sûr”, ignorant les failles kernel, les erreurs de configuration, et les attaques physiques. Certaines affirmations pourtant avérées fausses (« Il n’y a pas de malwares sous Linux » par exemple) circulent encore sur les forums sans être corrigées par la communauté.

- Dogme du tout logiciel : Croyance dans le fait que tout est logiciel et que le matériel est secondaire. Le logiciel et son code source font tout à eux seuls (performances, sécurité, fonctionnalités, connectivité, etc) indépendamment du hardware ou de l’infrastructure réseau.

- Le mythe de la supériorité éthique du libre : Le partage universel de la connaissance est un but moralement noble, mais l’évitement systématique de solutions propriétaires professionnelles payantes au profit de freewares open source, souvent issus de projets personnels hobbyistes (amateurs) à des fins de réutilisation professionnelle et commerciale pose un sérieux souci d’éthique et de concurrence loyale comme dans les exemples de Redhat ou WordPress.

« Une chose que vous faites, c’est empêcher l’écriture de bons logiciels. Qui peut se permettre de faire du travail professionnel gratuitement ? Quel hobbyiste peut mettre 3 années-homme dans la programmation, trouver tous les bugs, documenter son produit et le distribuer gratuitement ? »

Bill Gates – Lettre ouverte aux hobbyistes – février 1976

Red Hat vs CentOS :

L’approche du libre présente souvent de sérieuses incohérences, comme l’illustre l’arrêt brutal d’une distribution majeure de Linux qu’était CentOS par Red Hat, pour des raisons de concurrence avec ses propres produits « libres » mais en partie payants. Redhat reconnaît qu’il lui était impossible de maintenir CentOS totalement gratuitement, et que celui-ci faisait de l’ombre à RHEL pour lequel il existe des souscriptions payantes.

« CentOS handicapait nécessairement les ventes de RHEL en étant une alternative gratuite, mais aussi fonctionnelle. »

Le MagIT – Fin de vie de CentOS Linux : ce qu’il faut savoir – 11 octobre 2024

« L’existence même d’une version gratuite d’un système payant, alors que leurs fonctions étaient 100 % identiques, semait plus de la confusion qu’autre chose, à la fois pour les équipes commerciales de Red Hat et pour ses clients. »

Red Hat, acteur majeur de Linux et du monde FOSS, n’a eu aucun état d’âme pour les millions d’utilisateurs particuliers et entreprises utilisant CentOS pour protéger son propre business model, ne leur laissant d’autre choix que de migrer d’OS, chose qui peut être compliquée et que Red Hat propose de façon payante aux utilisateurs de CentOS 7 qu’ils laissent sur le carreau : « La nouvelle offre Red Hat Enterprise Linux for Third Party Linux Migration est conçue pour aider les utilisateurs de CentOS Linux 7 à assurer la continuité de leurs activités après la fin de vie du système. Proposée à un tarif compétitif, cette offre comprend une souscription Red Hat Enterprise Linux ainsi que des outils qui simplifient la conversion des instances CentOS Linux 7 existantes en systèmes Red Hat Enterprise Linux 7 »

WordPress vs WP Engine :

Un autre exemple est la querelle entre WordPress et WP Engine. WordPress, mécontent des modifications du code source par WP Engine pour ses clients, et du fait que malgré un chiffre d’affaire conséquent WP Engine ne contribue pas plus au financement et au code de WordPress, a tout simplement décidé de leur couper l’accès aux modules WordPress, laissant les clients de WP Engine sans mises à jour de sécurité sur les plug-ins et thèmes installés. En plus de cela WordPress s’est permis d’envoyer des messages directement aux clients de WP Engine et de s’approprier et « forker » un plug-in WP Engine!

Cela souligne une fois de plus le flou juridique encadrant l’usage de code libre et de sa propriété et de la limite de la souveraineté dans un écosystème open source dépendant largement de dépôts en ligne sous contrôle tiers. Il n’y a aucun droit opposable, ni dans un sens ni l’autre. On voit les limites de la promotion du libre comme levier de croissance et de souveraineté pour les entreprises et organisations numériques.

Ces cas emblématiques sont la conséquence logique de la problématique fondamentale de la rémunération et la durabilité du modèle libre. L’hypothèse d’un monde où tout serait produit gratuitement ignore la réalité économique de la maintenance, de la correction des bugs et des exigences de sécurité; les modèles hybrides (commercial + open core, OSPO, financements publics) sont souvent plus soutenables.

Sources :

- https://fr.wikisource.org/wiki/Page:Bill_Gates_Letter_to_Hobbyists_ocr.pdf/1

- https://www.lemagit.fr/conseil/Fin-de-vie-de-CentOS-7-et-maintenant-que-faire

- https://www.redhat.com/fr/technologies/linux-platforms/red-hat-enterprise-linux-for-third-party-linux-migration

- https://www.blogdumoderateur.com/wordpress-vs-wp-engine-conflit-consequences-ecosysteme-cms/

- https://wptavern.com/acf-plugin-forked-to-secure-custom-fields-plugin

- https://world.hey.com/dhh/automattic-is-doing-open-source-dirty-b95cf128

9. Souveraineté numérique : attention aux faux amis :

- MacOS, bien que propriétaire, est fermé matériellement et logiciellement, limitant l’autonomie.

- Android et iOS collectent des données personnelles massivement : photos, contacts, position, historique… bien plus que Windows 11 (ne pas confondre données personnelles et télémétrie).

- Google domine l’accès à l’information via Search et News, influençant la presse et les développeurs open source.

10. Les vrais critères de souveraineté numérique :

- Ouverture logicielle : La solution numérique permet-elle d’interagir facilement avec d’autres solutions tierces? Me permet-elle de créer facilement des données, du contenu et des applications que je peux librement diffuser?

- Ouverture matérielle : La base d’une solution numérique souveraine c’est le contrôle physique du matériel. Ordinateurs, serveurs, téléphonie, équipements réseaux. La solution mise en place permet-elle de librement choisir l’infrastructure matérielle sur laquelle je veux l’installer, l’exécuter et stocker les données (ordinateurs, serveurs, smartphones)?

- Confidentialité : La solution respecte t’elle ma vie privée ou la confidentialité des données mon entreprise? Quelle est la nature et le volume des données collectées et transmises vers fournisseurs de solutions numériques?

- Autonomie locale : La solution numérique permet-elle un déploiement totalement hors ligne à partir de sources d’installation? Dépend t’elle de comptes et services en ligne pour son installation ou son usage? Certaines solutions, pourtant on-premise, imposent quand même un compte en ligne pour les administrer.

- Extractibilité des données : Dans quelle mesure puis-je récupérer les données stockées dans un appareil numérique? (Par ex. démonter le disque dur d’un ordinateur et récupérer les données sur un autre ou une carte Micro SD sur un smartphone). Certaines solutions ne permettent pas un accès physique aux données.

- Exportabilité des données : la solution me permet-elle d’exporter les données dans un format standard compatibles avec d’autres solutions tierces concurrentes si je voulais en changer?

11. Recommandations pratiques pour une souveraineté numérique pragmatique :

- Choisir l’outil adapté au besoin : Linux pour serveurs spécialisés et flexibilité technique ; Windows on‑premise pour gestion centralisée, interopérabilité et simplicité opérationnelle ; éviter les décisions dictées par dogmes.

- Prioriser l’on‑premise pour les fonctions stratégiques (annuaire, messagerie, stockage critique) ou choisir un hébergement souverain bare‑metal localisé juridiquement.

- Ré-évaluer les coûts réels (humains et financiers) de la sécurisation des environnement Linux et open-source au regard des impératifs de sécurité et souveraineté (maintenance des packages, audit des dépendances, configuration avancée, solutions de sécurité EDR/XDR).

- Évaluer coûts énergétiques et performance des architectures : privilégier des binaires compilés locaux pour usages intensifs et limiter les applications web énergivores non optimisées.

- Favoriser des builds reproductibles et des miroirs on‑premise des dépôts critiques pour limiter les dépendances directes aux serveurs tiers.

- Renforcer la gouvernance open source : financement durable des mainteneurs, audits sécurité, politiques de gestion des comptes mainteneurs et revue des chaînes d’approvisionnement.

- Cartographier les dépendances et inventaire logiciel : lister repos, paquets critiques et mainteneurs, définir plans de reprise (forks, mirroirs internes).

- Pour les particuliers soucieux de leur souveraineté et de leur vie privée numérique, privilégier un ordinateur personnel pour gérer logiciels, photos et documents personnels en local (sans oublier de sauvegarder les données importantes sur d’autres supports physiques ou en ligne), plutôt que les smartphones nativement conçus pour la collecte de données personnelles et leur exploitation sur le cloud.

Conclusion

La souveraineté numérique n’est pas une question binaire « open source = souverain » vs « propriétaire = servitude ». Elle se mesure par la maîtrise des données, des chaînes logicielles et des infrastructures matérielles, ainsi que par la capacité à gouverner et financer la maintenance. Les logiciels libres sous Linux apportent des bénéfices importants, mais leur modèle de dépendances distribuées et leur fragmentation opérationnelle créent des risques réels pour la souveraineté si ces risques ne sont pas activement gérés. Pour beaucoup d’organisations et d’utilisateurs, des solutions on‑premise Microsoft Windows offrent aujourd’hui un compromis pragmatique : interopérabilité basée sur des standards, administration unifiée, binaires stables et contrôle juridique et physique des données. L’innovation utile ne dépend pas d’un label « libre » : elle dépend d’un écosystème qui finance la R&D, qui supporte le hardware et qui permet de maîtriser l’ensemble de la chaîne numérique.